오늘은 AI 기술에 관심 많은 분들이라면 꼭 주목해야 할 소식이에요. 단순한 AI 모델이 아니라, 앞으로 인공지능의 방향성과 책임(privacy, 윤리)의 새로운 기준이 될 구글의 VaultGemma 등장 소식입니다.

VaultGemma 전격 공개: AI + 개인 정보 보호의 결합

AI 기술이 발전하면서 반복되는 우려 중 하나는 개인정보 유출이에요. 학습 데이터에 포함된 민감한 정보가 모델 안에 ‘기억’되어 버리고, 이를 통해 외부로 노출될 가능성 말이에요.

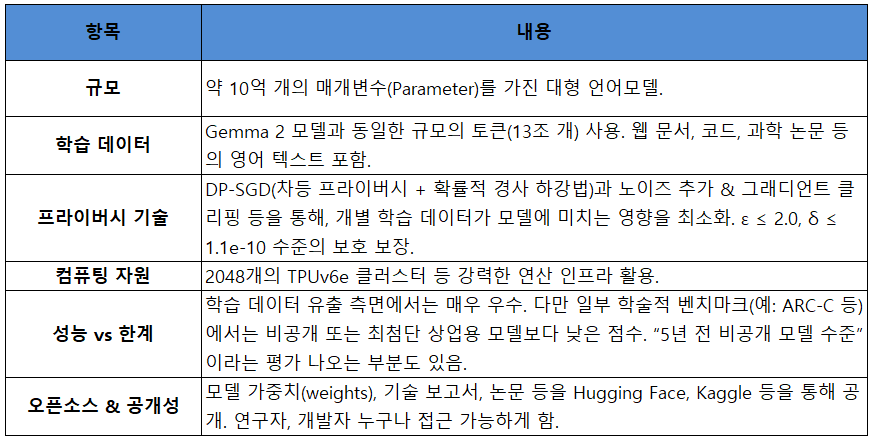

VaultGemma는 이 문제를 **처음부터 차등 프라이버시(Differential Privacy, 이하 DP)**를 적용해서 학습한, 구글과 딥마인드의 새로운 오픈소스 언어모델(LLM)입니다.

즉, 민감 데이터를 보호하는 것을 모델 설계의 출발점으로 삼은 거죠. 정말 의미 있는 변화예요.

VaultGemma, 뭐가 어떻게 특별한가?

왜 이게 주요한가? VaultGemma가 바꿀 것들

프라이버시 중심 AI 개발 표준화

개인정보 보호에 대한 규제가 강화되는 세계 흐름 속에서, VaultGemma는 “보안과 성능은 반드시 트레이드오프여야 한다”는 인식을 바꿀 수 있는 가능성을 보여줍니다.

의료·금융·공공기관 등 민감 분야 적용 확대

민감 데이터를 다루는 분야에서는 정보 유출 가능성이 가장 큰 걱정 중 하나였는데, VaultGemma 같은 모델은 이 걱정을 크게 낮출 수 있어요.

윤리적 AI·책임 있는 AI의 실제 구현

단순히 ‘AI가 똑똑해지자’가 아니라 ‘어떻게 똑똑해질 것인가’, ‘누구를 위험에 빠뜨리지 않을 것인가’ 등에 대한 고민이 기술 설계에 포함된다는 점이 중요해요.

경쟁 구도 변화 – 프라이버시 기술이 차별화 요소로

앞으로는 성능만큼이나 ‘프라이버시 보호 수준’이 AI 모델 선택의 중요한 기준이 될 가능성이 큽니다. 구글만이 아니라 다른 대형 AI 기업들도 이 쪽 분야 연구 강화할 거예요.

유의할 점과 앞으로의 과제

벤치마크 성능 차이: 사용자 체감 성능이나 특정 응용 분야에서는 최첨단 비공개 모델보다 낮을 수 있음.

리소스 비용: 차등 프라이버시 기법은 연산 비용, 학습 시간이 증가하는 경향 있음.

편향(bias) 및 일반화(generalization) 측면에서의 추가 연구 필요.

실제 애플리케이션 적용 시, 프라이버시 보호와 법적 / 윤리적 규제 준수 여부 점검 중요.

결론

VaultGemma는 구글이 공개한 단순한 언어모델 이상이에요. 성능만 추구하는 것이 아니라 프라이버시와 투명성을 초기부터 설계에 포함시킨 모델로, 앞으로 AI가 나아가야 할 방향을 명확하게 제시합니다.

AI 분야에 관심 많은 분들이라면, 지금 이 순간이 대단히 중요한 출발점이라는 걸 알아주시길 바랍니다. 기술적 완벽함보다는 책임 있는 혁신이 더욱 주목받는 시대에요.

댓글